玩转 ArgoDB:如何将数据流转至 ArgoDB

前言

大家好,前面我们介绍了如何通过 Beeline 连接 ArgoDB 数据,那么怎么实现跨平台数据流转呢?

企业在数字化建设的过程中,可能用到诸如 MySQL 之类的关系型数据库来为某些应用提供服务,那么如何将 MySQL 的数据快速导入到 ArgoDB 中,从而构建企业内的统一数据查询分析平台呢?具体流程如下:

接下来,我们将介绍具体的操作流程。

示例表的结构介绍

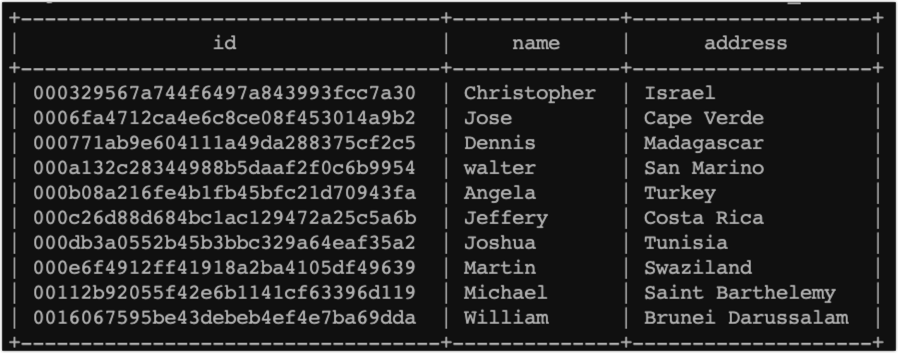

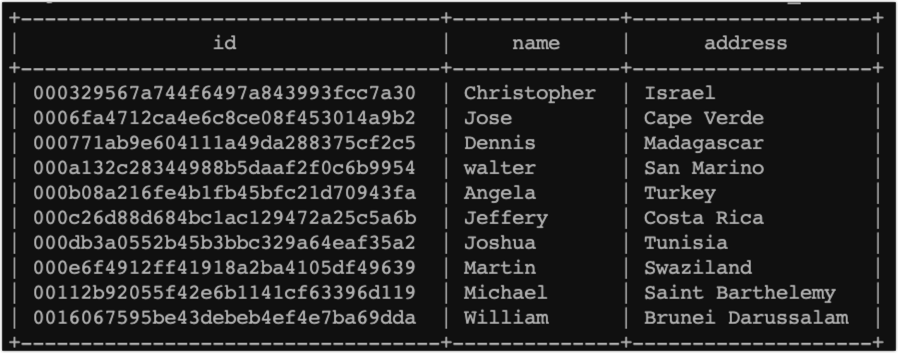

假设我们在 MySQL 数据库中,有一个 customer 表,其结构和样例数据如下:

具体操作

第一步:我们需要连接到 MySQL 数据库上,执行下述命令将表数据导出为 csv 文件:

select

id,

name,

country

from

customer into outfile '/root/customer.csv'

FIELDS TERMINATED BY ',' lines terminated by '\n';为统一格式以便后续识别,上述命令中,我们选择的字段分隔符为英文逗号,行终止符为换行符。

第二步:将数据文件上传到 HDFS

接下来,我们需要将 csv 文件上传到 ArgoDB 集群中的设备上,执行客户端初始化,其中初始化操作可参考我们之前介绍的 Beeline 连接数据库一文。

随后,我们执行下述命令,将 csv 文件上传到 HDFS 存储空间上,以便后续建表时读取该文件的数据:

创建存储目录:hadoop fs -mkdir /tmp/importdata

上传 csv 文件:hdfs dfs -put customer.csv /tmp/importdata/customer.csv第三步:创建文本外部表

现在,我们需要在 ArgoDB 中创建一个外部表,以便将其关联上刚刚上传的 csv 文件,我们可以使用以下命令创建名为 customer_csv 的外部表,字段分隔符和行终止符和前面导出表时的设置保持一致:

CREATE EXTERNAL TABLE customer_csv(

id STRING,

name STRING,

address STRING)

STORED AS CSVFILE LOCATION '/tmp/importdata/'

TBLPROPERTIES( 'field.delim'=',', 'line.delim'='\n');第四步:创建 Holodesk 表,该类型的表具有极强的数据处理性能,适用于聚合、过滤查询等场景。

执行下述命令,在 Holodesk 中创建一个名为 customer 的目标表,用于存储我们要导入的数据:

CREATE TABLE customer (

id STRING,

name STRING,

address STRING)

STORED AS HOLODESK;第五步:将文本外部表数据导入 Holodesk 表

这也是最后一步了,将数据从 customer_csv 外部表导入到 customer 表中,我们可以使用以下命令实现数据导入:

INSERT INTO customer SELECT * FROM customer_csv;导入成功时,会提示写入成功的具体行数,例如提示 “49,998 rows affected (1.193 seconds)”

通过以上步骤,我们成功地将 MySQL 数据导出为 csv 文件,并将其批量导入到 ArgoDB 中。现在,我们可以在 ArgoDB 上对这些数据进行查询和分析,以发掘有价值的信息。

导入数据到 ArgoDB 可以为我们提供更强大的数据分析和查询功能,同时还能利用其高性能计算能力和分布式存储优势,无论是处理大规模数据集还是进行复杂的数据分析,ArgoDB 都能帮助我们提高工作效率和数据处理能力,从而更好地支持决策和业务需求。

希望这篇帖子对您有所帮助,如果您对此有任何问题或者需要进一步的帮助,请随时在下方留言。

谢谢!

前言

大家好,前面我们介绍了如何通过 Beeline 连接 ArgoDB 数据,那么怎么实现跨平台数据流转呢?

企业在数字化建设的过程中,可能用到诸如 MySQL 之类的关系型数据库来为某些应用提供服务,那么如何将 MySQL 的数据快速导入到 ArgoDB 中,从而构建企业内的统一数据查询分析平台呢?具体流程如下:

接下来,我们将介绍具体的操作流程。

示例表的结构介绍

假设我们在 MySQL 数据库中,有一个 customer 表,其结构和样例数据如下:

具体操作

第一步:我们需要连接到 MySQL 数据库上,执行下述命令将表数据导出为 csv 文件:

select

id,

name,

country

from

customer into outfile '/root/customer.csv'

FIELDS TERMINATED BY ',' lines terminated by '\n';为统一格式以便后续识别,上述命令中,我们选择的字段分隔符为英文逗号,行终止符为换行符。

第二步:将数据文件上传到 HDFS

接下来,我们需要将 csv 文件上传到 ArgoDB 集群中的设备上,执行客户端初始化,其中初始化操作可参考我们之前介绍的 Beeline 连接数据库一文。

随后,我们执行下述命令,将 csv 文件上传到 HDFS 存储空间上,以便后续建表时读取该文件的数据:

创建存储目录:hadoop fs -mkdir /tmp/importdata

上传 csv 文件:hdfs dfs -put customer.csv /tmp/importdata/customer.csv第三步:创建文本外部表

现在,我们需要在 ArgoDB 中创建一个外部表,以便将其关联上刚刚上传的 csv 文件,我们可以使用以下命令创建名为 customer_csv 的外部表,字段分隔符和行终止符和前面导出表时的设置保持一致:

CREATE EXTERNAL TABLE customer_csv(

id STRING,

name STRING,

address STRING)

STORED AS CSVFILE LOCATION '/tmp/importdata/'

TBLPROPERTIES( 'field.delim'=',', 'line.delim'='\n');第四步:创建 Holodesk 表,该类型的表具有极强的数据处理性能,适用于聚合、过滤查询等场景。

执行下述命令,在 Holodesk 中创建一个名为 customer 的目标表,用于存储我们要导入的数据:

CREATE TABLE customer (

id STRING,

name STRING,

address STRING)

STORED AS HOLODESK;第五步:将文本外部表数据导入 Holodesk 表

这也是最后一步了,将数据从 customer_csv 外部表导入到 customer 表中,我们可以使用以下命令实现数据导入:

INSERT INTO customer SELECT * FROM customer_csv;导入成功时,会提示写入成功的具体行数,例如提示 “49,998 rows affected (1.193 seconds)”

通过以上步骤,我们成功地将 MySQL 数据导出为 csv 文件,并将其批量导入到 ArgoDB 中。现在,我们可以在 ArgoDB 上对这些数据进行查询和分析,以发掘有价值的信息。

导入数据到 ArgoDB 可以为我们提供更强大的数据分析和查询功能,同时还能利用其高性能计算能力和分布式存储优势,无论是处理大规模数据集还是进行复杂的数据分析,ArgoDB 都能帮助我们提高工作效率和数据处理能力,从而更好地支持决策和业务需求。

希望这篇帖子对您有所帮助,如果您对此有任何问题或者需要进一步的帮助,请随时在下方留言。

谢谢!

.jpg)